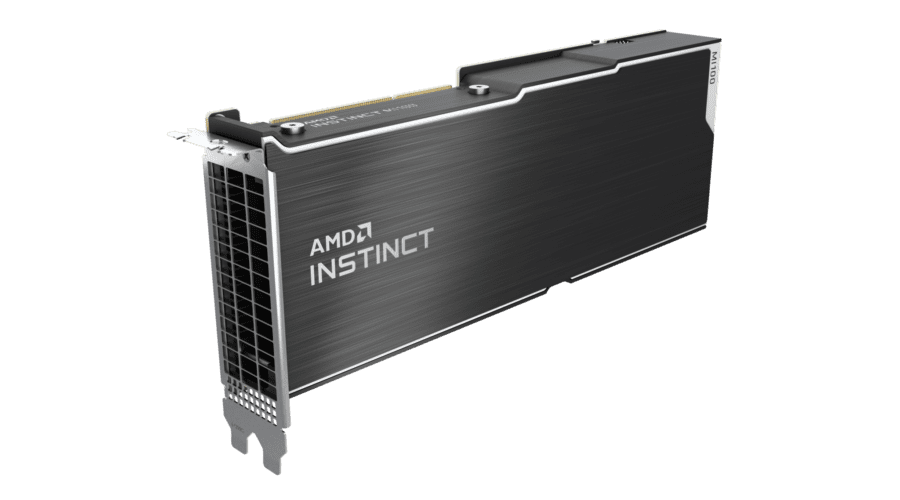

AMD a anunțat lansarea noului accelerator AMD Instinct MI100 – cel mai rapid GPU HPC din lume și primul GPU pentru server x86 care depășește bariera de performanță a celor 10 teraflops (FP64).

Fiind suportat de HPE și Supermicro, acceleratoarele MI100, în combinație cu procesoare AMD EPYC și platforma open software ROCm 4.0, sunt concepute pentru a propulsa noi descoperiri în era exascale.

Construită cu ajutorul noii arhitecturi AMD CDNA, GPU-ul AMD Instinct MI100 permite o nouă clasă de sisteme accelerate pentru HPC și AI atunci când este asociat cu procesoare AMD EPYC de a doua generație.

MI100 oferă până la 11,5 TFLOPS de performanță de vârf FP64 pentru HPC și până la 46,1 TFLOPS de vârf FP32 Matrix de performanță pentru AI și sarcini de lucru de machine learning. Cu noua tehnologie AMD Matrix Core, MI100 oferă, de asemenea, o creștere de aproape 7 ori în performanța teoretică de vârf FP16 pentru sarcini de lucru de formare AI, comparativ cu acceleratoarele de generație anterioară ale AMD.

Software-ul de dezvoltator AMD ROCm oferă baza pentru calculul exascale. Ca un set de instrumente open source format din compilers, API-uri de programare și biblioteci, ROCm este utilizat de dezvoltatorii de software exascale pentru a crea aplicații de înaltă performanță.

Funcțiile AMD Instinct MI100 includ:

- Noua arhitectură AMD CDNA – Proiectată pentru a alimenta GPU-urile AMD pentru era exascale, fiind în centrul acceleratorului MI100, arhitectura AMD CDNA oferă performanțe foarte bune și eficiență energetică

- Performanță FP64 și FP32 de top pentru sarcinile de lucru HPC – Oferă performanțe de vârf FP64 de 11,5 TFLOPS și performanțe FP32 de vârf de 23,1 TFLOPS, permițând oamenilor de știință și cercetătorilor din întreaga lume să accelereze descoperirile din varii industrii, inclusiv biologie, energie, finanțe, universități, guvern, apărare.

- Noua tehnologie Matrix Core pentru HPC și AI – Performanță supraalimentată pentru o gamă completă de operații cu matrice de precizie unică și mixtă, cum ar fi FP32, FP16, bFloat16, Int8 și Int4, proiectate pentru a spori convergența HPC și AI.

- Tehnologia AMD Infinity Fabric de a doua generație – Instinct MI100 oferă lățimea de bandă I/O de vârf peer-to-peer (P2P) peste PCIe 4.0 cu până la 340 GB/s de lățime de bandă agregată pe card cu trei AMD Infinity Fabric Links. Într-un server, GPU-urile MI100 pot fi configurate cu până la două hive-uri GPU quad complet conectate, fiecare furnizând până la 552 GB/s de lățime de bandă P2P I/O pentru partajarea rapidă a datelor.

- Memorie HBM2 ultrarapidă – Dispune de memorie HBM2 cu lățime de bandă de 32 GB la o rată de clock de 1,2 GHz și oferă o lățime de bandă de memorie foarte mare de 1,23 TB/s pentru a susține seturi mari de date și pentru a ajuta la eliminarea blocajelor în mișcarea datelor din memorie.

- Suport pentru cel mai recent PCIe® Gen 4.0 din industrie – Proiectat cu cea mai recentă tehnologie PCIe Gen 4.0 care oferă până la 64 GB/s lățime teoretică de bandă pentru transportul datelor de la CPU la GPU.

Specificații MI100

| Compute Units | Stream Processors | FP64 TFLOPS (Peak) | FP32 TFLOPS (Peak) | FP32 Matrix TFLOPS (Peak) | FP16/FP16 Matrix (Peak) | INT4 | INT8 TOPS (Peak) | bFloat16 TFLOPs (Peak) | HBM2 | Memory Bandwidth |

| 120 | 7680 | Up to 11.5 | Up to 23.1 | Up to 46.1 | Up to 184.6 | Up to 184.6 | Up to 92.3 TFLOPS | 32GB | Up to 1.23 TB/s |